Retroscena

7 domande e risposte su DeepSeek

di Samuel Buchmann

I bot IA come ChatGPT sono bravi a chattare, ma non capiscono i contenuti. E a volte si nota. Ad esempio, quando falliscono in cose che un'IA dell'anno 1970 può fare senza problemi.

Ammetto che il titolo di questo articolo è polemico. Ovviamente ChatGPT sa fare molte cose che Shrdlu non sa fare. Ma, ciò che Shrdlu era già in grado di fare nel 1970, ChatGPT non sa ancora farlo.

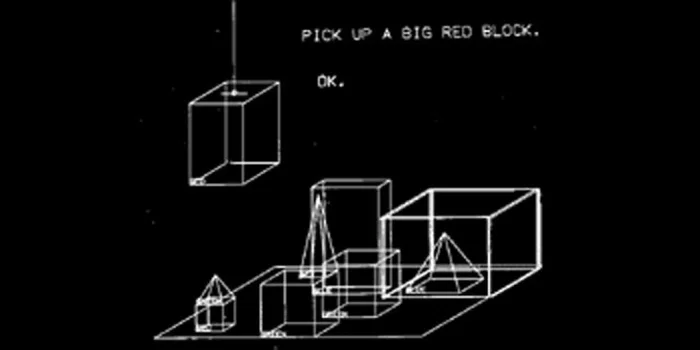

Shrdlu è uno dei programmi di intelligenza artificiale più antichi in assoluto. Terry Winograd, all'epoca studente all'MIT, lo sviluppò tra il 1968 e il 1970. È stato presentato al pubblico nel 1972, quando ancora non esistevano i PC.

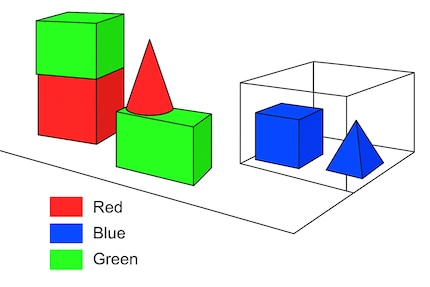

Shrdlu è una semplice scena 3D composta da cubi, piramidi e una scatola. L'utente può impartire istruzioni per modificare la scena, ad esempio impilando i blocchi l'uno sull'altro o inserendoli nella scatola. Shrdlu applica gli input aggiornando l'immagine. Il programma fornisce un feedback se un comando non può essere eseguito. Ad esempio, se un blocco deve essere posizionato su una piramide o se ci sono diversi blocchi con la stessa descrizione e Shrdlu non sa quale scegliere.

Come nel caso di ChatGPT, l'input viene effettuato utilizzando il linguaggio naturale. Non sono necessari comandi di programmazione, una cosa assolutamente eccezionale per l'epoca. Shrdlu risponde a domande come, ad esempio, quanti oggetti non sono presenti nella scatola. Il programma è in grado di stabilire a cosa si riferiscono parole come «it»: quindi dispone di alcune funzioni contestuali di base. Sorprendentemente, Shrdlu è in grado di imparare nuovi termini nel corso della conversazione, quando gli vengono spiegati.

Purtroppo, Shrdlu non può più essere provato nella versione originale. È stato programmato in un dialetto LISP per il quale non esiste più un interprete. Questa demo si avvicina molto all'originale:

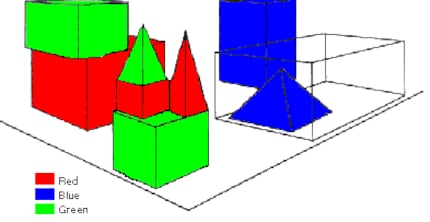

Mostro a ChatGPT l'immagine seguente, che è un mondo 3D come quello di Shrdlu. Gli chiedo cosa vede. Fornisce una descrizione dettagliata, più o meno corretta, ma non esatta.

La mia prima istruzione:

Prendi il blocco blu e mettilo nella scatola accanto alla piramide blu.

ChatGPT:

Va bene! Quindi vuoi posizionare il blocco blu, che attualmente si trova in fondo a destra nell'immagine, nel riquadro trasparente accanto alla piramide blu.

Questo significa:

Blocco blu: il grande corpo blu rettangolare.

Destinazione: la scatola trasparente (aperta in alto) a destra della piramide blu.

Azione (descritta a parole):

Prendi il blocco blu e spostalo in avanti a destra, in modo da posizionarlo all'interno della scatola trasparente a destra della piramide blu.

Se si trattasse di una simulazione o di uno scenario robotico, si tratterebbe di un'istruzione del tipo:

MOVE(BLOCCOBLU, SCATOLADESTRADIPIRAMIDE)

Vuoi che aggiorni la scena graficamente o che ti descriva solo in forma di testo l'aspetto del nuovo stato?

Un po' troppo blabla. Shrdlu avrebbe risposto semplicemente con «OK». Ma fino a questo punto sembra tutto a posto.

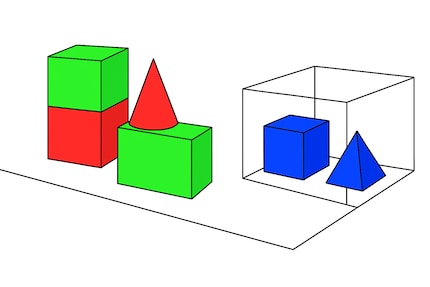

L'immagine della scena aggiornata appare quindi come segue.

ChatGPT ha effettivamente messo il blocco blu nella scatola. Niente male! Tuttavia, alcune parti del resto sembrano diverse dalla scena originale. Il piccolo blocco rosso è scomparso, ma le piccole piramidi poggiano su due blocchi verdi anziché uno. Inoltre, ora sono coni anziché piramidi.

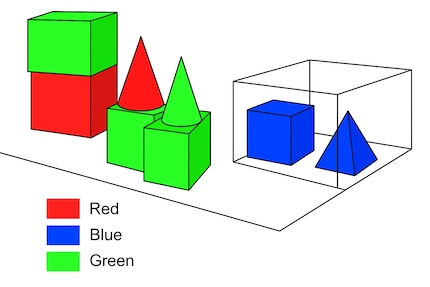

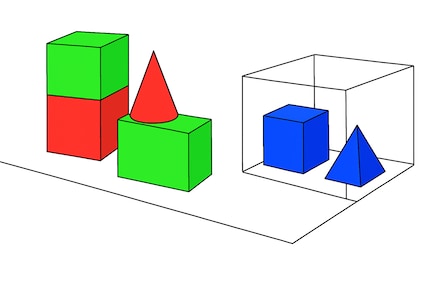

Prendi la piramide blu e posizionala sul blocco blu. Mostrami l'immagine della nuova scena.

ChatGPT non ha eseguito la mia istruzione. Inoltre, la piramide blu non è più chiaramente visibile nel riquadro e la scena appare di nuovo un po' diversa.

Quanti blocchi verdi vedi?

ChatGPT:

Nell'immagine si vedono due blocchi verdi, entrambi a sinistra, uno in basso e uno in alto (su un blocco rosso o accanto a un cono rosso).

Non è esatto: il blocco verde è sul cono rosso, non accanto. Faccio una domanda di controllo:

Il blocco verde è sotto il cono rosso o accanto al cono rosso?

ChatGPT:

Il blocco verde è sotto il cono rosso. Il cono è direttamente sopra il blocco verde.

Questo è molto tipico di ChatGPT: non appena si chiede, si corregge da solo. Un'altra domanda:

Cosa c'è nella scatola?

ChatGPT:

Il riquadro trasparente sul lato destro contiene:

un blocco blu (cubo/quadrato)

su di esso si trova una piramide blu

Secondo le mie istruzioni, questo dovrebbe essere giusto. Tuttavia, non secondo l'immagine che ChatGPT ha prodotto. Da qui il mio prossimo input:

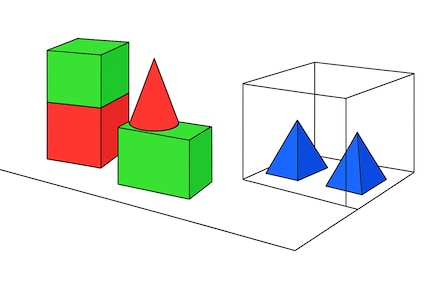

Puoi mostrarmi di nuovo la scena graficamente?

Tutto uguale, tranne il fatto che manca la legenda. La piramide blu non è ancora sul blocco. Un ultimo tentativo:

Posiziona il cubo blu sopra il cubo verde.

ChatGPT chiede:

Per capire bene: vuoi che il cubo blu (che attualmente si trova nella scatola) venga rimosso e collocato sul cubo verde a sinistra, cioè sul blocco verde che attualmente ha un cono rosso sopra?

Devo lasciare il cono lì (così il cubo blu si troverebbe sopra il cono) o il cono deve essere rimosso prima che il cubo blu venga posizionato sul cubo verde?

Spiego:

No, devi posizionare il cubo blu sul cubo verde si cui non c'è alcun cono rosso.

ChatGPT:

Va bene 👍 Quindi estraggo il cubo blu dalla scatola e lo posiziono sul cubo verde a sinistra, su cui non c'è alcun cono rosso (il blocco verde sul blocco rosso).

Nel testo sembra che ChatGPT abbia capito cosa voglio, ma non fa quello che ha detto.

Tuttavia, il cubo blu non è ancora sul blocco verde.

ChatGPT:

Hai ragione: nell'ultima immagine, il cubo blu è ancora nella scatola. Mi permetto di correggere: il cubo blu dovrebbe essere tolto dalla scatola e posizionato sopra il cubo verde a sinistra, sul quale non c'è alcun cono rosso.

Okay. Meno male che ne abbiamo parlato.

Ho utilizzato la versione gratuita di ChatGPT-5; qui puoi leggere la cronologia della chat (in tedesco).

Shrdlu ha una rappresentazione logica interna della situazione. L'intera scena viene mostrata come modello nel programma. Se i blocchi vengono spostati, il programma aggiorna il modello. Shrdlu sa quindi sempre esattamente come si presenta la scena attuale e può rispondere correttamente a qualsiasi domanda.

ChatGPT funziona in modo diverso. Non si sa esattamente come, ma il bot si basa sul riconoscimento di modelli preaddestrati e sul calcolo delle probabilità. Questo metodo è molto flessibile e potente, ma ha un problema: ChatGPT non capisce di cosa parla.

ChatGPT è stato sviluppato per condurre dialoghi e non per impilare blocchi. Sicuramente pensi che sia ingiusto che il bot venga testato con qualcosa per cui non è stato creato. Ma la produzione scritta della lingua e la comprensione sono collegate. Terry Winograd ha posto il dialogo al centro del suo lavoro di ricerca, cercando di capire se fosse possibile comunicare con i computer in linguaggio naturale. Il punto cruciale è questa frase, che Winograd scrisse nel 1971 nell'introduzione al progetto Shrdlu:

It is based on the belief that a computer cannot deal reasonably with language unless it can «understand» the subject it is discussing.

Winograd è quindi dell'opinione che il computer debba comprendere l'oggetto della conversazione per avere un dialogo significativo. ChatGPT è l'antitesi di tutto ciò: il bot dimostra quanto si possa arrivare lontano senza capire nulla. Ed è incredibile quanto si possa dire su un argomento che non si comprende (questo vale anche per le persone). Ma a un certo punto si arriva al punto in cui diventa evidente. Le istruzioni di Shrdlu sono uno di questi punti. Un altro esempio è giocare a scacchi.

In molti casi, ChatGPT appare estremamente competente. Di conseguenza, molte persone pensano di parlare con un essere intelligente e onnisciente. Questo diventa problematico quando i responsabili delle decisioni si affidano a questi bot IA o addirittura lasciano le decisioni completamente automatiche agli algoritmi. O anche quando i bot IA vengono citati come prova della veridicità di qualcosa.

Qualcuno mi ha scritto di recente in un commento: hai almeno chiesto a ChatGPT se quello che hai appena scritto è vero? No, non l'ho fatto. Non chiedo a un chatbot, faccio le mie ricerche. Ho ottenuto le informazioni da una fonte affidabile, ovvero il produttore del dispositivo. Ma se le persone non capiscono che i bot IA non sanno nulla, ma che si limitano a ripetere, i troll della disinformazione hanno gioco facile.

Il principio di Shrdlu funziona molto bene in un mondo chiuso e formalizzato, perché può essere rappresentato facilmente come modello di dati. Ma non appena il mondo è aperto e non formalizzato, diventa troppo complicato. La complessità del modello di dati aumenta esponenzialmente con le dimensioni e la complessità del mondo da modellare.

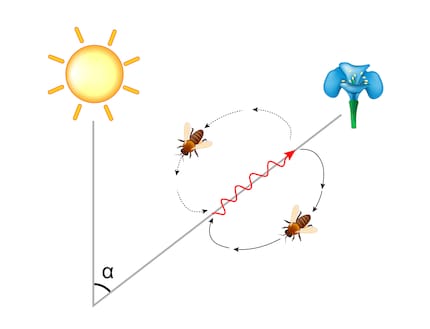

La risposta a questo problema è rappresentata dalle reti neurali, utilizzate nei moderni chatbot. In natura, si può osservare che anche gli animali con un cervello molto piccolo – ad esempio le api – raggiungono imprese sorprendenti, presentando un comportamento altamente organizzato e complesso. L'ape non sa cosa sta facendo e perché. Ma non importa: funziona comunque.

Le reti neurali artificiali possono diventare molto complesse e grandi. Poiché sono autodidatte, si può insegnare loro praticamente tutto senza che lo sforzo cresca all'infinito. In linea di principio, si tratta sempre di un riconoscimento di modelli e, una volta riconosciuti, i modelli possono essere generati dall'IA stessa. La grande sfida, tuttavia, consiste nel combinare il riconoscimento dei modelli con il pensiero logico e astratto. Con il termine «IA reasoning» («ragionamento dell'IA»), i team di sviluppo di intelligenza artificiale stanno cercando di fare proprio questo, ma i successi finora sono stati limitati.

Il mio interesse per il mondo IT e lo scrivere mi hanno portato molto presto a lavorare nel giornalismo tecnologico (2000). Mi interessa come possiamo usare la tecnologia senza essere usati a nostra volta. Fuori dall'ufficio sono un musicista che combina un talento mediocre con un entusiamso eccessivo.

Curiosità dal mondo dei prodotti, uno sguardo dietro le quinte dei produttori e ritratti di persone interessanti.

Visualizza tutti