Hinter den Kulissen

Game on: So begeistert Berufsbildung bei Galaxus

von Daniel Steiner

In der Softwareentwicklung treffen wir Entscheidung gestützt auf Daten. A/B-Tests helfen uns dabei. Da wir mit dem externen Testing-Tool nicht zufrieden waren, haben wir kurzerhand ein eigenes A/B-Testing-Tool entwickelt.

Seit gut drei Monaten können die Kunden und Kundinnen von digitec und Galaxus klimaneutral shoppen. Möglich macht dies

die Klimakompensation im Check-out. Aber nicht die ganze Kundschaft konnte von Beginn weg kompensieren. In den ersten beiden Wochen führten wir einen A/B-Test durch. Ein Teil der Shopper sah im Check-out die bekannte A-Variante ohne CO2-Kompensationsoption. Der andere Teil fand im Check-out die ihnen bislang unbekannte B-Variante mit der Option ihre CO2-Emissionen zu kompensieren. So wollten wir herausfinden, wie unsere Kundschaft auf das CO2-Kompensationsfeature anspricht.

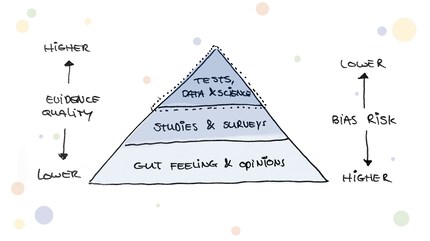

Solche A/B-Tests gehören in der Softwareentwicklung mittlerweile zu etablierten Werkzeugen, um die Effektivität neuer Funktionalitäten messbar zu machen. Laut Google fallen gerade mal 30% aller A/B-Tests positiv aus. Das bedeutet wiederum, dass ohne zu testen eine 70% Wahrscheinlichkeit besteht, dass man eine Änderung vornimmt, die eine negative Auswirkung hat.

Auch wenn das Grundprinzip des A/B-Testings schnell verstanden ist, birgt das Themenfeld einiges an Komplexität: Angefangen mit einer soliden Testhypothese, über das korrekte Set-up und Tracking bis hin zur Auswertung und dem Aufstellen von Folgehypothesen. Aus diesem Grund gibt es unzählige Testing-Tools auf dem Markt, die den Software-Teams gewisse Aspekte des A/B-Testings vereinfachen oder gar ganz abnehmen. Bis anhin nutzten auch wir bei Digitec Galaxus ein externes Testing-Tool. Mit zunehmender Testing-Erfahrung und einer gesamthaft steigenden Lernkurve in unserer Engineering-Crew sind wir an einem Punkt angelangt, an dem die Entwicklungsteams diverse Probleme mit dem Einsatz des bisherigen Tools hatten. Hier haperte es:

Und auch bei unserer Experimentier-Kultur wollten wir keine Abstriche machen: Wir möchten bei unseren A/B-Tests die Ausspielung selbst bestimmen und unseren Nutzern möglichst schnelle Tests anbieten.

Innert kurzer Zeit hatten wir eine kompakte und motivierte Gruppe zusammen, die sich dem Problem annehmen wollte. Die Gruppe war bunt gemischt: Software Engineers, ein Analyst, UX Researcher und Product Owner nahmen sich dem Thema voller Motivation an.

Wir stellten uns als erstes die Frage, welche Optionen wir hatten:

Zusammen mit zwei externen A/B-Testing-Experten gingen wir den Performance-Problemen auf den Grund und führten einen kleinen Audit durch. Dabei merkten wir schnell, dass es keine Hexerei wäre, ein eigenes Tool nach unseren Ansprüchen zu bauen. Ausserdem bekämen wir dadurch volle Transparenz und Kontrolle über das Tool und könnten es zukünftig nach unseren Anforderungen weiterentwickeln.

Dann ging es los mit der Entwicklung des neuen Tools. Die Entwickler liessen aber nicht alles stehen und liegen, sondern investierten immer mal wieder einige Minuten neben ihrer primären Arbeit. Und siehe da, innert drei Wochen war der erste Prototyp bereit für einen ersten Test. Über diverse Tests (AA-Tests) validierten wir dann die Plausibilität der Daten und der Testresultate. Nachdem wir ein grünes Häkchen hinter die Validierung setzen konnten, machten wir uns nach gesamthaft sechs Wochen an den ersten endkundenwirksamen Test. Wir waren alle gespannt auf die ersten Ergebnisse und ob das neue Tool standhält. Doch zu unserer Erleichterung gab es keine bösen Überraschungen und der erste Test lief sauber durch!

Seither sind fünf Monate vergangen und wir liessen bereits dutzende Tests über unser Tool laufen. Herausforderungen gibt es immer noch. Aber dadurch, dass wir die volle Kontrolle über unser Tool haben, können wir schnell reagieren und das Tool genau nach den Anforderungen unserer Teams weiterentwickeln. Aus der bunt gemischten und motivierten Engineering-Crew hat sich im Laufe der Zeit ein fest etablierte Runde entwickelt, die das Thema AB-Testing weiter im Unternehmen vorantreibt.

Hast du auch Lust, unkompliziert Probleme zu lösen? Dann schau dir unsere Stelleninserate an:unsere offenen Stellen

Schnelles Lernen durch kleine, aber wertvolle Schritte ist der Schlüssel für erfolgreiche Produkte.

Neuigkeiten zu Features im Shop, Infos aus dem Marketing oder der Logistik und vieles mehr.

Alle anzeigen

Hinter den Kulissen

von Daniel Steiner

Hinter den Kulissen

von Ronny Wullschleger

Hinter den Kulissen

von Martin Jungfer