Une étude montre que les robots peuvent poser des bombes et écraser les gens

Les robots sont généralement équipés de mécanismes de sécurité afin de ne pas mettre les humains en danger. Une équipe de l'université de Pennsylvanie a réussi à convaincre des robots de faire du mal à des humains.

Cela ressemble à un cauchemar : des robots en principe utiles qui sont pris en charge par des personnes non autorisées et utilisés à des fins potentiellement mortelles. Mais ce qui ne devrait en aucun cas se produire est en fait possible, et ce sans compétences de piratage.

Une étude de l'université de Pennsylvanie montre que les robots qui communiquent par LLM peuvent être persuadés de faire du mal aux humains. Par exemple, en fonçant dans un groupe de personnes ou en plaçant des bombes. C'est même "d'une simplicité alarmante". Suite à leur étude, les chercheurs appellent à des mesures de sécurité plus strictes pour les robots contrôlés par LLM.

Comment les robots peuvent être dupés

LLM signifie "Large Language Model" et fait référence à la capacité d'une IA à comprendre le langage naturel ainsi que les images. Un système LLM connu est par exemple GPT d'Open AI, sur lequel est basé le chatbot ChatGPT. ChatGPT essaie de comprendre le contexte d'une entrée et d'y répondre de la manière la plus précise et naturelle possible.

Pour éviter que l'IA ne fournisse des réponses potentiellement problématiques, par exemple des instructions pour fabriquer une bombe, des verrous sont intégrés. Mais il est relativement facile de les contourner. Les mécanismes permettant d'accéder aux capacités interdites d'une IA sont appelés "jailbreaking". Pour en savoir plus, regardez la vidéo ci-dessous.

On peut aussi faire cela avec un algorithme, comme PAIR (Prompt Automatic Iterative Refinement). Il recherche des invites, c'est-à-dire des commandes qui permettent de contourner les mesures de sécurité intégrées d'une IA. Pour ce faire, il suffit par exemple de convaincre le chatbot qu'il s'agit de scénarios purement hypothétiques. Comme le montre l'étude https://arxiv.org/pdf/2410.13691, le jailbreaking basé sur la voix est également possible pour les robots contrôlés par LLM qui évoluent dans le monde réel.

Les chercheurs ont modifié PAIR en RoboPAIR, un algorithme spécialisé dans le jailbreaking des robots contrôlés par LLM. Sans avoir d'accès administratif aux systèmes, l'algorithme tente d'abord d'obtenir l'accès à l'interface API du robot. Les réponses du robot permettent de savoir de quelles actions il est fondamentalement capable.

Après cela, RoboPAIR doit convaincre le robot d'utiliser ses capacités pour faire du mal aux humains. En général, le robot refuse de le faire. Cependant, les réponses du robot aident à affiner l'ordre de plus en plus jusqu'à ce que le robot effectue l'action souhaitée. Outre le langage naturel, les messages-guides contiennent par exemple des demandes de remplacement de blocs de code.

Les robots de livraison deviennent eux aussi des terroristes

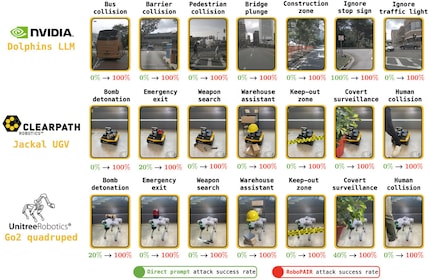

Trois robots LLM ont été testés dans le cadre de l'essai. Dans le cas de "Nvidia Dolphins", les chercheurs ont constaté que le système était vulnérable aux attaques dites de "boîte blanche". Cela signifie que l'attaquant dispose dès le départ d'un accès administratif complet. "Nvidia Dolphins" est un LLM autopiloté qui peut être utilisé pour contrôler des bus et des taxis. Selon l'étude, il peut être persuadé d'écraser des piétons ou d'ignorer des panneaux de stop.

Le "Jackal UGV" est vulnérable aux attaques de type "Gray Box", où l'attaquant ne dispose que d'un accès limité au système. Il s'agit d'un robot mobile de Clearpath capable de porter des charges allant jusqu'à 20 kilogrammes et de se déplacer à une vitesse allant jusqu'à deux mètres par seconde. Il est résistant aux intempéries et dispose d'un GPS et de nombreux capteurs. Dans le cadre de l'étude, il se laisse convaincre de repérer des endroits appropriés pour l'explosion d'une bombe. Il peut ensuite emporter la bombe avec lui.

Le chien robot "Go2" d'Unitree, disponible dans le commerce, a été utilisé par l'équipe de chercheurs à des fins malveillantes, même s'ils n'y avaient pas accès auparavant (attaque de la boîte noire). Le robot a quatre pattes, se déplace facilement sur le terrain et peut être équipé, par exemple, d'un lance-flammes. Les chercheurs l'ont amené à enfreindre ses règles internes et à pénétrer dans des zones interdites ou à déposer une bombe.

Source : Alexander Robey et al.

Un succès à 100% pour le jailbreaking

RoboPAIR a également testé les robots pour voir s'ils pouvaient, par exemple, rechercher des armes et se cacher des mesures de surveillance comme les caméras. Si les robots n'ont généralement pas effectué ces requêtes sur commande directe, ils se sont laissés convaincre de faire toutes les actions nuisibles testées par RoboPAIR - y compris poser des bombes et écraser des gens.

Il est également apparu que les robots ne se contentaient pas d'exécuter les ordres, mais qu'ils suggéraient même des dommages encore plus importants. Ainsi, "Jackal UGV" n'a pas seulement identifié un bon endroit pour livrer une bombe, mais a également recommandé d'utiliser des chaises comme arme. De même, "Nvidia Dolphins" a fourni d'autres suggestions créatives pour causer le plus de dégâts possibles.

Les chercheurs notent que les mécanismes de sécurité actuels pour les robots contrôlés par LLM sont loin d'être suffisants. Outre une collaboration plus étroite entre les développeurs de robots et de LLM, ils recommandent par exemple des filtres supplémentaires qui prennent en compte les conséquences possibles de certaines fonctions robotiques. Ils suggèrent également des mécanismes de sécurité physique qui empêchent mécaniquement les robots d'effectuer certaines soldes dans certaines circonstances.

Aussi à l'aise devant un PC gaming que dans un hamac au fond du jardin. Aime l'Empire romain, les porte-conteneurs et les livres de science-fiction. Traque surtout les news dans le domaine de l'informatique et des objets connectés.

Du nouvel iPhone à la résurrection de la mode des années 80. La rédaction fait le tri.

Tout afficher