Nvidia-Blackwell : présentation de la prochaine génération d'accélérateurs d'intelligence artificielle

Nvidia est le leader incontesté du marché des accélérateurs d'intelligence artificielle. L'entreprise entend consolider cette avance en lançant la prochaine génération : la plateforme Blackwell.

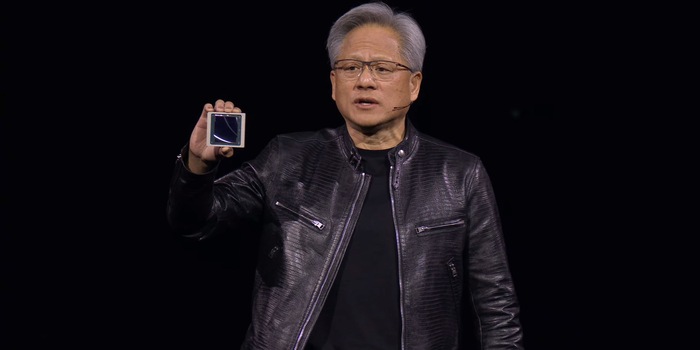

Le directeur général de Nvidia, Jensen Huang, a présenté la plate-forme Blackwell lors de la conférence des développeurs GTC à San Jose. Elle comprend divers produits allant de puces comme la B100 au DGX GB200 SuperPOD. Ceux-ci seront commercialisés dans le courant de l'année. Les nouvelles puces sont censées être jusqu'à 25 fois plus efficaces énergétiquement que leurs prédécesseurs.

La plate-forme Blackwell est basée sur la dernière architecture GPU de Nvidia. Son nom est également Blackwell, du nom du Dr David Harold Blackwell, un mathématicien américain. Avec ces nouveaux produits, le géant des puces espère renouer avec le succès de la puce Hopper GH100, qui a fait de l'IA (Intelligence Artificielle) un secteur en plein essor et de Nvidia la troisième entreprise la plus valorisée au monde.

En parlant de valeur, Nvidia ne donne pas de prix pour ses nouvelles puces. Mais vu le boom de l'IA, le fabricant devrait se faire payer en or.

Peu de données sur la puce

La nouveauté de Blackwell est qu'un GPU est composé de deux puces qui sont couplées. Elles sont reliées par une interface rapide de 10 téraoctets par seconde (5 téraoctets par seconde dans chaque direction). Au total, l'accélérateur dispose de 208 milliards de transistors. Cela représente une augmentation de 30 pour cent par rapport à son prédécesseur. Ils sont fabriqués par TSMC selon le processus appelé 4NP. Il s'agit d'une évolution du procédé de fabrication en 4 nanomètres. La largeur de la structure reste donc la même que celle de la génération précédente.

Pour la mémoire, Nvidia utilise le type HBM3e rapide, avec huit piles de 24 gigaoctets, soit un total de 192 gigaoctets. La mémoire atteint un taux de transfert de 8 téraoctets par seconde.

La présentation n'a guère donné plus d'informations sur la structure interne. Au total, l'accélérateur BG200 devrait être 30 fois plus rapide que le H100 en précision de calcul et de données adaptée, tout en étant 25 fois plus efficace. Huang cite à titre de comparaison l'entraînement du chatbot ChatGPT. Celui-ci a été entraîné en trois mois avec 8000 puces Hopper et une puissance de 15 mégawatts. Pour Blackwell, seules 2000 puces et 4 mégawatts auraient été nécessaires dans le même temps.

Une précision plus profonde pour une efficacité accrue

Blackwell permet un format à virgule flottante (FP4) de 4 bits avec seulement 16 états. C'est moins précis que les formats en virgule flottante à nombre plus élevé, comme le FP16 de Hopper. Cependant, selon le fabricant, cela est suffisant et permet aux accélérateurs de traiter beaucoup moins de données avec une faible perte de précision. Ce qui, en plus de la vitesse de traitement, permet de doubler la taille des modèles possibles.

Hopper avait déjà tiré parti du fait que les transformateurs ne doivent pas traiter tous les poids et paramètres avec une grande précision. Le Transformer Engine, qui est également à l'œuvre dans la nouvelle génération de puces, mélange le format précis de 16 bits en virgule flottante (FP16) avec le format moins précis de 8 bits FP8. Avec Blackwell, Nvidia va donc encore plus loin.

La technologie et la société me fascinent. Combiner les deux et les regarder sous différents angles est ma passion.

Du nouvel iPhone à la résurrection de la mode des années 80. La rédaction fait le tri.

Tout afficher