Retroscena

Apple iOS 14.5: privacy per l'Internet moderno

di Dominik Bärlocher

Apple sta per lanciare un sistema in grado di identificare gli abusi sui minori sugli smartphone. Dopo un ulteriore controllo manuale, vengono informate le autorità. Sembra un’ottima idea... ma per la privacy è un vero incubo.

Apple vuole adottare misure contro la pedopornografia e gli abusi sui minori, e annuncia un sistema che analizza le fotografie direttamente sul tuo dispositivo. In caso di sospetti, le invia poi a operatori in carne e ossa per un ulteriore controllo. Se i sospetti sono confermati, negli USA viene allertato il National Center for Missing and Exploited Children (NCMEC). Giovedì scorso Apple ha pubblicato un white paper sulla questione. Il sistema si chiama NeuralHash e sarà incluso nelle prossime versioni di iOS 15 e iPadOS 15.

Tuttavia Apple si è cacciata in un ginepraio della IT security: sicurezza o privacy? Quale dei due è più importante?

Ad esclusione del white paper, in questa storia ci sono ben pochi fatti. Le domande sollevate dal NeuralHash non riguardano tanto una tecnologia e le sue applicazioni, ma piuttosto i diritti umani. Ecco quindi un riepilogo di tutto quello devi sapere per comprendere il resto dell’articolo. Nota: nel resto dell’articolo mi riferisco ad Apple per rappresentare tutte le aziende tecnologiche, e NeuralHash per rappresentare tutti i sistemi che funzionano secondo un principio simile.

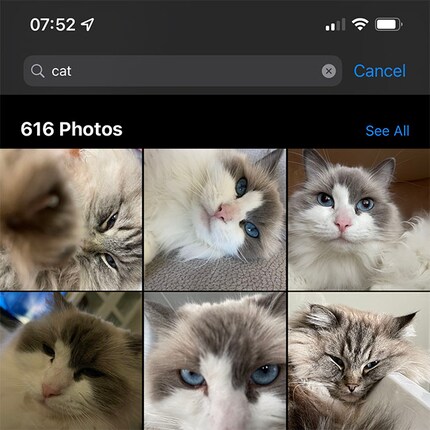

Il tuo smartphone analizza già il contenuto delle tue fotografie. Puoi verificarlo in un attimo: apri l’app Galleria e usa la funzione di ricerca. Se cerchi «gatto» appariranno fotografie del tuo gatto. Ma anche di altri gatti.

Questo succede perché l’app Galleria carica sul tuo smartphone le cosiddette impronte digitali, ovvero parametri che definiscono qual è l’aspetto di un gatto. In parte, anche tu puoi definirli. Se visualizzo una foto di Stephanie Tresch, la nostra video producer, Apple non riconosce la donna dell’immagine.

Posso però dare un nome all’immagine: il record di dati «signora» diventa «signora, Stephanie Tresch». Appena l’app Foto di Apple sa che «signora» corrisponde anche a «Stephanie Tresch» viene creata un’impronta digitale per «Stephanie Tresch». Il colore degli occhi, gli zigomi, le labbra, le sopracciglia, le posizioni, le posizioni combinate a oggetti (ad esempio: se inserisco «Zurigo Hardbrücke» + «ore 14:00» + «cappotto blu» + «videocamera» mi vengono mostrate delle immagini di Stephanie vista da dietro che regge la videocamera), ecc.

Ogni file di immagini, proprio come qualsiasi altro file, ha un proprio numero che può essere calcolato. Si chiama valore di hash. L’hash è più piccolo del file di immagini quindi è più efficiente a livello di database.

Quando invii un selfie alla tua migliore amica, all’immagine viene assegnato un valore di hash. Se lei la rispedisce a sua volta, l’immagine inviata ha sempre lo stesso hash. Se però l’immagine viene modificata, ad esempio viene convertita da colori in bianco e nero, anche l’hash cambia.

Grazie a questa tecnologia è possibile seguire singole immagini se vengono etichettate come «non buone» da un’autorità centrale. Soprattutto nel caso della pornografia non autorizzata, dove le immagini vengono condivise e fatte girare, il tracciamento dell’hash può favorire un rapido successo nelle ricerche. Se però l’immagine viene continuamente modificata, rintracciarle con l’hash è più difficile.

Gli hash possono essere modificati con metodi molto semplici.

Il lancio di NeuralHash è già confermato. Questo sistema opera più o meno come la funzione di ricerca dell'app Galleria: indicizza automaticamente le immagini secondo determinati criteri. Nel nostro caso sarebbero immagini di «abusi su minori». Se NeuralHash individua un certo numero di immagini corrispondenti all’impronta digitale di «abusi su minori», le immagini vengono decodificate e inviate ad Apple.

Se la persona che verifica le immagini conferma i sospetti, negli USA viene allertato il National Center for Missing and Exploited Children (NCMEC). Come affermato dalla stessa organizzazione, NCMEC collabora con «autorità di tutto il mondo» e si oppone al diffuso e indiscusso impiego della crittografia end-to-end nell’interesse dei minori.

In base a quanto riportato a pagina 5 del white paper, diversamente dai normali hash, NeuralHash crea un numero partendo dal contenuto anziché dai dati di un’immagine. NeuralHash guarda l’immagine, capisce cosa raffigura e genera un numero relativo. Di conseguenza, anche se un’immagine a colori viene convertita in bianco e nero, il NeuralHash resta invariato. E non cambia nemmeno se varia la dimensione del file, o se l’immagine viene ritagliata. In questo modo Apple vuole aggirare la manipolazione dell’hash da parte degli utenti.

Dal punto di vista tecnico non è necessario che un dipendente di Apple conosca il tuo ID Apple. I dipendenti hanno solo il compito di determinare se sussiste o meno il reato di abuso sui minori. Il collegamento tra immagine e utente può avvenire nelle profondità del database Apple e non richiede obbligatoriamente che chi controlla sappia che l’immagine X provenga dalla persona X. La persona che controlla deve solo rispondere alla domanda «L’immagine X mostra abusi su minori?», se questo non risulta già dall’hash dell’immagine.

Un diritto umano è qualcosa di cui gode o dovrebbe godere qualsiasi persona, dovunque e in qualsiasi momento. È inalienabile, ovvero non può essere ceduto o venduto. I diritti umani sono anche indivisibili: non è possibile difendere il diritto umano A e nel contempo opporsi al diritto umano B.

Nell’articolo 12 della Dichiarazione universale dei diritti umani le Nazioni Unite definiscono chiaramente la privacy come diritto umano:

Nessun individuo potrà essere sottoposto a interferenze arbitrarie nella sua vita privata, nella sua famiglia, nella sua casa, nella sua corrispondenza, né a lesione del suo onore e della sua reputazione. Ogni individuo ha diritto ad essere tutelato dalla legge contro tali interferenze o lesioni.

Apple condivide questi principi e ha dichiarato di considerare la privacy uno dei suoi pilastri:

La privacy è un diritto umano inalienabile. Ed è anche uno dei valori fondanti di Apple.

Stessa musica in casa Google. Anche Facebook, in qualità di piattaforma social il cui meccanismo centrale è la condivisione pubblica di quelli che un tempo erano dati privati, si dà molto da fare per assicurare che i tuoi dati non finiscano nelle mani sbagliate.

Nel 2021 Apple risulta il marchio più influente al mondo. Da questa posizione deriva, come si capisce dal titolo dell’articolo, un grande potere. Qualsiasi cosa faccia, Apple dà il via a una reazione a catena. Senza contare che, inoltre, il resto del mondo tecnologico ha bisogno di Apple molto più di quanto Apple abbia bisogno del resto del mondo tecnologico.

Ti faccio un esempio: Tile produce dei tracker Bluetooth dal 2013. Tile però non è mai riuscita a sfondare perché, tra le altre cose, non ha una rete estesa di dispositivi in grado di rintracciare l’oggetto smarrito. Nel 2021 Apple presenta l’AirTag. Tutto d’un tratto, grazie alla funzionalità «Find My» network, puoi contare su un miliardo di dispositivi in tutto il mondo per trovare il tuo AirTag. Ora Tile può accedere alla rete «Find my» network. Ovvero Tile ha bisogno di Apple molto più di quanto Apple abbia bisogno di Tile.

Il cosiddetto «Apple effect», ovvero il potere del marchio combinato alla reazione a catena, non deve essere sottovalutato. Quando Apple introduce una nuova funzionalità danneggia in qualche modo le aziende concorrenti che quella funzionalità già la offrivano, mettendole in difficoltà.

NeuralHash ha portato molto scompiglio nel campo dell'IT Security e tra i sostenitori della privacy. Le obiezioni sollevate non sono solo di natura tecnologica, ma soprattutto etico-filosofica.

Se Apple vuole andare alla ricerca di segni di abusi sui minori nelle tue foto, deve prima bypassare il sistema di codifica dei tuoi backup su iCloud. In NeuralHash viene quindi creata un’impronta digitale «abuso su minori», che viene poi integrata nell’app Foto.

Secondo quanto spiegato a pagina 4 del white paper l’app Foto controlla le immagini sul tuo iPhone bypassando completamente qualsiasi codifica. Apple ha così trovato un modo per tenere il piede in due staffe: avere un sistema di crittografia e bypassarlo contemporaneamente. Infatti le immagini sul tuo iPhone sono salvate come testo normale.

In gergo tecnico, questa si chiama «backdoor». Per il momento Apple è ancora in grado di mantenere un certo livello di crittografia, anche se la crittografia completa non è altro che un miraggio. Questo succede perché l’FBI e il governo USA hanno fatto notevoli pressioni. Attualmente, quindi, Apple ha la possibilità di decodificare i backup. Per quanto ne sappiamo, è possibile intervenire sulla backdoor solo tramite il canale di aggiornamento ufficiale di Apple.

Perché NeuralHash sia efficace contro gli abusi sui minori è necessario che qualcuno definisca che tipo di immagini rappresenta un abuso. E anche a partire da quale livello di abuso deve intervenire il sistema. Per l’impronta digitale «abuso su minori» è sufficiente un «occhio nero»? O il sistema interviene solo quando a un «occhio nero» si aggiunge anche un «labbro insanguinato»?

Chi lo decide? Su che cosa si basano queste decisioni? Come viene definito «sufficientemente grave» un abuso su un minore?

A peggiorare le cose, secondo quanto riportato a pagina 3 del white paper, NeuralHash è invisibile e tu non puoi controllarlo in alcun modo.

Una volta che NeuralHash sarà liberato tra le persone non potrà più essere fermato. Nel momento in cui l’app Galleria sarà in grado di riconoscere Stephanie Tresch da dietro basandosi sul suo cappotto blu e sul fatto che tiene in mano una videocamera in un determinato luogo, quella stessa funzione di ricerca potrà essere applicata praticamente a tutto e tutti.

Chi può prometterci che Apple non farà un uso improprio di questa funzionalità?

NeuralHash può essere utilizzato per scopi legittimi e illegittimi. È molto plausibile che, dopo gli abusi sui minori, si passerà alla caccia al melanoma. Però è altrettanto possibile che Apple crei un gigantesco archivio di immagini di peni, perché NeuralHash prevede che le immagini possano essere decodificate e trasmesse.

Gli esperti di sicurezza informatica come Matthew Green, docente di crittografia, temono che NeuralHash rappresenti un attacco alla crittografia end-to-end.

«È un’idea spaventosa che può portare alla sorveglianza di massa dei nostri notebook e smartphone» ha dichiarato al Financial Times Ross Anderson, docente di Security Engineering presso l’università di Cambridge.

Con NeuralHash sei costantemente sotto controllo. Sul tuo smartphone. Un dispositivo di cui, nella quotidianità, è difficile fare a meno. Questo monitoraggio è centralizzato ed è gestito da persone su cui non hai alcun controllo. Persino la legge può intervenire solo in modo limitato su sistemi come NeuralHash. Da un lato perché i legislatori del mondo sono interessatissimi alle backdoor. Dall’altro perché le legislature delle democrazie spesso sono solo reattive e lente. Fino a quando la legge non si occuperà in modo approfondito e continuativo di NeuralHash, il sistema non soltanto sarà lasciato in mano agli uomini, ma verrà ulteriormente sviluppato.

L’esecutivo di qualsiasi sistema ha grande interesse perché NeuralHash si affermi con successo. Un sistema di questo tipo consentirebbe di catturare individui sospettati di terrorismo prima che commettano reati. Se il sistema venisse esteso a includere i dati sulla posizione, si potrebbero arrestare i criminali in base alla loro localizzazione al momento del crimine. Se a NeuralHash viene fornita un’impronta digitale del «luogo del crimine» + «abbigliamento» + «ora del crimine» potrebbe essere possibile creare un profilo del criminale e dei suoi spostamenti perché magari il criminale appare sullo sfondo di un selfie scattato da una cliente del caffè situato di fronte al luogo del crimine. Il lavoro della polizia verrebbe facilitato e si potrebbe applicare la giustizia in modo più efficiente.

È possibile che i governi possano costringere Apple a installare NeuralHash, configurato in base a fattori arbitrari, su tutti gli iPhone del loro paese. Ecco un esempio macroscopico: il governo cinese potrebbe dire: «Apple, non puoi più vendere iPhone in Cina a meno che NeuralHash non ci aiuti a rintracciare gli uiguri».

Se Apple dovesse opporsi a questa richiesta perderebbe una fetta enorme di mercato. Se invece accettasse, sarebbero in molti a patirne le conseguenze.

Le decisioni di Apple creano sempre reazioni a catena. «Darà la stura a molte altre cose», ha dichiarato al Financial Times Matthew Green, docente di security alla John Hopkins University, «I governi pretenderanno che tutti implementino la funzionalità».

L’effetto Apple sarebbe messo a dura prova e potrebbe costituire un pericoloso precedente. Se Apple si piegasse alle sue richieste, nulla potrebbe impedire alla Polonia di avviare una caccia agli omosessuali usando NeuralHash. O alle donne in Iran che non indossano lo hijab.

Quando NeuralHash cerca immagini di violenza, scansiona elementi che possono presentarsi non soltanto in seguito ad atti di violenza. «Occhio nero», «labbro insanguinato» e altre condizioni simili si ritrovano anche nello sport. Cristiane Justino Venâncio, lottatrice di UFC con il nome d’arte di Cris Cyborg, al termine di ogni incontro e a volte anche mentre combatte, è conciata davvero male.

Se avesse un numero sufficiente di fotografie con il naso sanguinante o un occhio nero, NeuralHash interverrebbe. Un certo numero di immagini verrebbe inviato ad Apple, dove una persona incaricata le esaminerebbe. Una situazione del genere non è rara nella quotidianità di Cris Cyborg. Un dipendente di Apple se ne accorgerebbe e chiuderebbe il ticket. Nel frattempo, però, avrebbe visto le immagini.

Un falso positivo, quindi, non è soltanto una violazione dei diritti umani, ma anche qualcosa che accade senza un valido motivo. Un tizio qualsiasi di Apple si guarda un paio di immagini dall’archivio privato della lottatrice. Senza alcun motivo.

Bisogna chiedersi allora se i cosiddetti «falsi positivi» siano giustificabili. Se sì, quante volte può verificarsi un falso positivo prima che NeuralHash si spinga troppo oltre? Chi decide qual è il numero giusto di volte? Chi controlla questo numero?

A pagina 3 del white paper Apple afferma che il numero di falsi positivi è «estremamente basso». Nella pagina seguente si parla di un falso positivo ogni trilione di casi esaminati. Inoltre tutti i rapporti sarebbero stati controllati prima di essere inviati all’NCMEC.

Possiamo fidarci di Apple?

Apple deve il proprio buon nome al fatto di considerare la privacy un pilastro portante della propria filosofia aziendale. Ma Apple non è obbligata in alcun modo a conservarlo.

Per le aziende, l’ideologia è sempre uno strumento di marketing. Nonostante quello che dice il CEO, alle aziende non interessa fare del bene in giro per il mondo. Quello che conta davvero sono i soldi. Apple deve vendere iPhone. Definisce degli obiettivi di crescita che deve raggiungere e, non appena i conti smettono di tornare, cambia direzione. Come farebbe qualsiasi altra azienda.

Le case automobilistiche si trovano proprio nel mezzo di un cambio di direzione. Mentre dieci anni fa Tesla veniva liquidata come una stramberia, ora interi marchi stanno passando dalla benzina all’elettrico. Per il bene dell’ambiente, ovviamente. Non perché i legislatori emanano leggi sempre più restrittive per i veicoli a benzina, promettono sgravi fiscali per chi acquista auto elettriche, e perché la gente vuole acquistare veicoli elettrici.

Che cosa garantisce che Apple resterà per sempre la paladina della privacy che è oggi?

Nonostante tutti i nobili obiettivi che Apple vuole perseguire con NeuralHash, la funzione è troppo pericolosa per non essere considerata un rischio eccessivo per la privacy intesa come diritto umano. Non possiamo fidarci così tanto di Apple. Così come di nessun’altra azienda. E soprattutto non possiamo fidarci dei legislatori. A un’organizzazione che si oppone attivamente alla crittografia end-to-end non dovrebbe essere concesso di utilizzare, senza alcun tipo di supervisione, un meccanismo per bypassare le codifiche. Indipendentemente dalle motivazioni.

La privacy deve restare inviolabile. Non possono esserci eccezioni. Anche i criminali hanno diritti umani.

Anche se un’eccezione potrebbe avere effetti molto positivi, costituirebbe comunque un precedente che non garantisce un risultato positivo.

Giornalista. Autore. Hacker. Sono un contastorie e mi piace scovare segreti, tabù, limiti e documentare il mondo, scrivendo nero su bianco. Non perché sappia farlo, ma perché non so fare altro.

Curiosità dal mondo dei prodotti, uno sguardo dietro le quinte dei produttori e ritratti di persone interessanti.

Visualizza tutti