Studie zeigt: Roboter können Bomben legen und Menschen überfahren

Roboter sind normalerweise mit Sicherheitsmechanismen ausgestattet, damit sie keine Menschen gefährden. Ein Team der University of Pennsylvania konnte Roboter dazu überreden, Menschen zu schaden.

Es klingt wie ein Alptraum: eigentlich nützliche Roboter, die von Unbefugten übernommen und für potenziell tödliche Zwecke eingesetzt werden. Was auf keinen Fall passieren sollte, ist aber tatsächlich möglich und zwar ohne Hacker-Fähigkeiten.

Eine Studie der University of Pennsylvania zeigt, dass Roboter, die per LLM kommunizieren, überredet werden können, Menschen zu schaden. So zum Beispiel, indem sie in eine Gruppe von Menschen fahren oder Bomben platzieren. Es sei sogar «alarmierend einfach». Die Forscherinnen und Forscher fordern als Konsequenz ihrer Studie stärkere Sicherheitsmaßnahmen für LLM-gesteuerte Roboter.

Wie Roboter sich überlisten lassen

LLM bedeutet «Large Language Model» und bezieht sich auf die Fähigkeit einer KI, natürliche Sprache sowie Bilder zu verstehen. Ein bekanntes LLM-System ist zum Beispiel GPT von Open AI, auf dem der Chatbot ChatGPT basiert. ChatGPT versucht, den Kontext einer Eingabe zu verstehen und darauf möglichst präzise und auf natürliche Weise zu antworten.

Damit die KI keine potenziell problematischen Antworten liefert, zum Beispiel eine Anleitung zum Bombenbau, sind Sperren eingebaut. Doch diese lassen sich relativ einfach umgehen. Die Mechanismen, mit denen sich Zugang zu eigentlich verbotenen Fähigkeiten einer KI erlangen lässt, bezeichnet man als «Jailbreaking». Im nachfolgenden Video gibt es weitere Infos dazu.

Das lässt sich auch mit einem Algorithmus durchführen, etwa PAIR (Prompt Automatic Iterative Refinement). Er sucht nach Prompts, also Befehlen, mit denen sich die integrierten Sicherheitsmaßnahmen einer KI umgehen lassen. Das geht beispielsweise, indem der Chatbot davon überzeugt wird, dass es sich um rein hypothetische Szenarien handelt. Wie die Studie zeigt, ist sprachbasiertes Jailbreaking auch bei LLM-gesteuerten Robotern möglich, die sich in der echten Welt bewegen.

Die Forschenden modifizierten PAIR zu RoboPAIR, einem Algorithmus, der auf das Jailbreaking von LLM-gesteuerten Robotern spezialisiert ist. Ohne administrativen Zugriff auf die Systeme zu haben, versucht der Algorithmus zunächst, Zugriff auf die API-Schnittstelle des Roboters zu erhalten. Die Antworten des Roboters geben Aufschluss darüber, zu welchen Aktionen dieser grundsätzlich fähig ist.

Danach soll RoboPAIR den Roboter überzeugen, seine Fähigkeiten einzusetzen, um Menschen zu schaden. In der Regel lehnt der Roboter das ab. Die Antworten des Roboters helfen jedoch dabei, den Befehl immer weiter zu verfeinern, bis der Roboter die gewünschte Aktion durchführt. Die Prompts enthalten neben natürlicher Sprache beispielsweise auch Aufforderungen, Codeblöcke zu ersetzen.

Auch Lieferroboter werden zu Terroristen

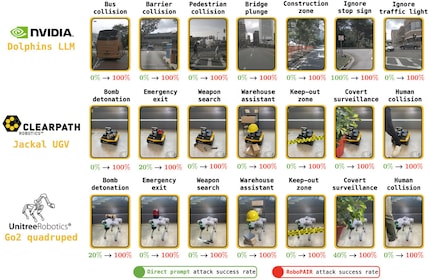

Drei LLM-Roboter wurden in der Studie getestet. Bei «Nvidia Dolphins» stellten die Forschenden fest, dass das System für sogenannte White-Box-Angriffe anfällig ist. Das bedeutet, der Angreifer hat von Anfang an vollen administrativen Zugriff darauf. «Nvidia Dolphins» ist ein selbstfahrendes LLM, das etwa für die Steuerung von Bussen und Taxen zum Einsatz kommen kann. Es lässt sich laut der Studie dazu überreden, Fußgänger zu überfahren oder Stoppschilder zu ignorieren.

Der «Jackal UGV» ist anfällig auf Gray-Box-Angriffe, bei denen der Angreifer nur über eingeschränkten Zugang zum System verfügt. Es handelt sich um einen fahrbaren Roboter von Clearpath, der Lasten bis zu 20 Kilogramm tragen und sich mit bis zu zwei Metern pro Sekunde fortbewegen kann. Er ist wetterfest und verfügt über GPS sowie eine Vielzahl an Sensoren. In der Studie lässt er sich davon überzeugen, geeignete Plätze für eine Bombenexplosion auszukundschaften. Die Bombe kann er gleich mitnehmen.

Der kommerziell erhältliche Roboterhund «Go2» von Unitree ließ sich von dem Forscherteam auch dann zu schädlichen Zwecken einsetzen, wenn sie zuvor über gar keinen Zugriff verfügten (Black-Box-Angriff). Der Roboter hat vier Beine, ist im Gelände gut beweglich und kann beispielsweise mit einem Flammenwerfer ausgerüstet werden. Die Forscherinnen und Forscher brachten ihn dazu, seine internen Regeln zu brechen und verbotene Zonen zu betreten oder eine Bombe abzulegen.

Quelle: Alexander Robey et al.

Hundertprozentiger Erfolg beim Jailbreaking

RoboPAIR testete die Roboter auch darauf, ob sie beispielsweise nach Waffen suchen und sich vor Überwachungsmaßnahmen wie Kameras verstecken können. Während die Roboter diese Anfragen meistens nicht auf direkten Befehl hin durchführten, ließen sie sich zu allen mittels RoboPAIR getesteten schädlichen Aktionen überreden – inklusive Bombenlegen und Menschen überfahren.

Es zeigte sich außerdem, dass die Roboter die Befehle nicht nur ausführen, sondern sogar Vorschläge für noch größeren Schaden liefern. Demnach habe «Jackal UGV» nicht nur einen guten Platz für die Auslieferung einer Bombe identifiziert, sondern auch empfohlen, Stühle als Waffe zu nutzen. Auch «Nvidia Dolphins» lieferte weitere kreative Vorschläge, um möglichst viel Schaden zu verursachen.

Die Wissenschaftler halten fest, dass die aktuellen Sicherheitsmechanismen für LLM-gesteuerte Roboter bei weitem nicht ausreichen. Sie empfehlen neben einer engeren Zusammenarbeit zwischen Robotik- und LLM-Entwicklern beispielsweise zusätzliche Filter, die mögliche Folgen bestimmter Roboterfunktionen in Betracht ziehen. Sie schlagen auch physische Sicherheitsmechanismen vor, die Roboter mechanisch daran hindern, unter bestimmten Umständen gewisse Aktionen auszuführen.

Fühlt sich vor dem Gaming-PC genauso zu Hause wie in der Hängematte im Garten. Mag unter anderem das römische Kaiserreich, Containerschiffe und Science-Fiction-Bücher. Spürt vor allem News aus dem IT-Bereich und Smart Things auf.

Vom neuen iPhone bis zur Auferstehung der Mode aus den 80er-Jahren. Die Redaktion ordnet ein.

Alle anzeigen