Google lässt seinen Chatbot frei – er ist zurückhaltender als der von Microsoft

«Bard», der auf Google LaMDA basierende Chatbot, startet in die öffentliche Testphase. Die ersten Experimente zeigen eine schlechtere Fakten-Trefferquote als bei Microsofts «Bing».

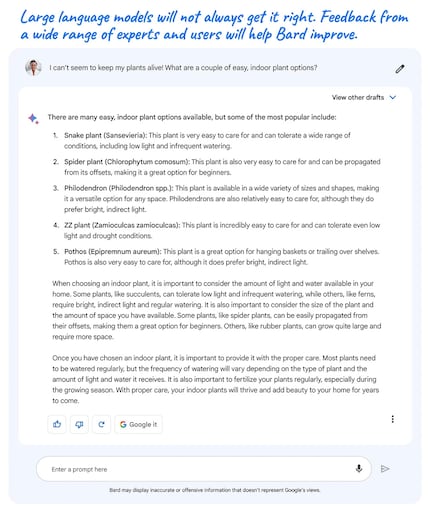

Seit Mittwoch ist Googles Chatbot «Bard» für die Öffentlichkeit verfügbar, wenn auch zunächst nur in Grossbritannien und den USA. Wer dort wohnt, kann sich auf dieser Website für den Testlauf der Künstlichen Intelligenz (KI) anmelden. Das vermeldet Google in einer Pressemitteilung. Ziel sei es, ein breites Feedback zu erhalten.

Bereits in seiner Meldung dämpft Google die Erwartungen: «Bard ist ein Experiment», steht in einem grossen Disclaimer. Large-Language-Modelle wie LaMDA, auf dem Bard basiert, seien eine neue Technologie. Diese würde noch viele Fehler mit sich bringen. Das Unternehmen weist insbesondere darauf hin, dass die KI auch Misinformation und Stereotypen reproduziert. Trotzdem bestehe viel Potenzial, beispielsweise um die menschliche Produktivität zu steigern oder Kreativität anzuregen.

Quelle: Google

Erste Erfahrungsberichte auf verschiedenen US-Techportalen fallen verhalten aus. Google scheint demnach einen sehr vorsichtigen Weg zu gehen und hat Bard enge Grenzen gesetzt. Er entschuldigt sich oft und erinnert die User daran, dass er nur ein Chatbot ist. Dunkle Seiten oder eine streitsüchtige Persönlichkeit konnte bisher niemand aus Bard herauskitzeln – ganz anders als bei Microsofts «Bing», der in seiner ersten öffentlichen Version einen Journalisten drängte, sich von seiner Frau zu trennen und eine Beziehung mit der KI einzugehen.

Die engen Grenzen schränken anscheinend gleichzeitig Bards Nutzen ein. Gemäss Tech-Portal «The Verge» liegt Googles Chatbot sehr oft faktisch falsch – viel öfter als Bing. In vielen anderen Fällen gebe Bard ausserdem sehr langweilige Antworten. «Er ist definitiv keine Suchmaschine», schreibt Autor David Pierce. Und genau wie Bing sei auch Bard ein extrem selbstsicherer Lügner.

«Engadget» merkt an, dass Googles Modell Quellen nur angibt, wenn er sie direkt zitiert. Bing hingegen versieht seine Antworten mit viel mehr Links zum Ursprung seines Wissens. Dafür bietet Bard die Möglichkeit, «weitere Entwürfe» der Antwort zur selben Frage zu generieren.

Titelbild: Shutterstock

Mein Fingerabdruck verändert sich regelmässig so stark, dass mein MacBook mich nicht erkennt. Der Grund: Sitze ich nicht vor einem Bildschirm oder stehe hinter einer Kamera, hänge ich oft an den Fingerspitzen in einer Felswand.

Vom neuen iPhone bis zur Auferstehung der Mode aus den 80er-Jahren. Die Redaktion ordnet ein.

Alle anzeigen