Nvidia-Blackwell: Nächste KI-Beschleuniger-Generation vorgestellt

Nvidia führt den Markt für KI-Beschleuniger unangefochten an. Diesen Vorsprung will das Unternehmen weiter ausbauen und bringt die nächste Generation: die Blackwell-Plattform.

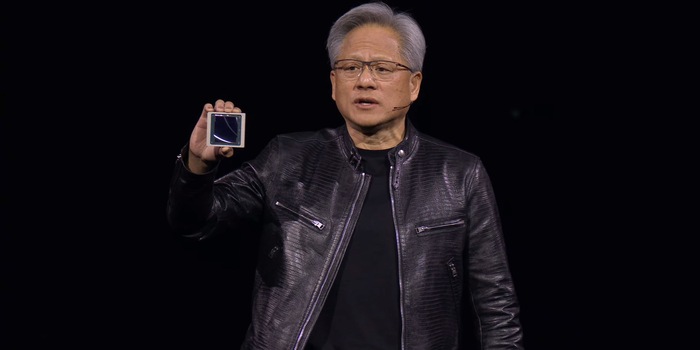

Nvidia-Chef Jensen Huang hat an der hauseigenen Entwicklerkonferenz GTC in San Jose die Blackwell-Plattform vorgestellt. Sie beinhaltet diverse Produkte von Chips wie dem B100 bis zum DGX GB200 SuperPOD. Diese kommen im Verlauf des Jahres auf den Markt. Die neuen Chips sollen bis zu 25 Mal energieeffizienter sein als die Vorgänger.

Die Blackwell-Plattform basiert auf der neuesten GPU-Architektur von Nvidia. Deren Name ist ebenfalls Blackwell, benannt nach Dr. David Harold Blackwell, einem US-amerikanischen Mathematiker. Mit den neuen Produkten will der Chipgigant an den Erfolg des Hopper-Chips GH100 anknüpfen, der KI (Künstliche Intelligenz) zur Boombranche und Nvidia zum drittwertvollsten Unternehmen der Welt gemacht hat.

Apropos Wert: Preise für die neuen Chips nennt Nvidia nicht. Angesichts des andauernden KI-Booms dürfte sich der Hersteller die Dinger jedoch vergolden lassen.

Wenig Daten zum Chip

Neu bei Blackwell ist, dass eine GPU aus zwei Chips besteht, die gekoppelt sind. Verbunden sind sie über ein 10 Terabyte pro Sekunde schnelles Interface (5 Terabyte pro Sekunde pro Richtung). Insgesamt verfügt der Beschleuniger über 208 Milliarden Transistoren. Das entspricht im Vergleich zum Vorgänger einem Zuwachs von 30 Prozent. Hergestellt werden sie bei TSMC im 4NP-genannten Prozess. Dabei handelt es sich um eine Weiterentwicklung der 4-Nanometer-Fertigung. Die Strukturbreite bleibt damit gleich wie bei der Vorgängergeneration.

Beim Speicher verwendet Nvidia den schnellen Typ HBM3e. und zwar gleich acht 24-Gigabyte-Stapel, was insgesamt 192 Gigabyte ergibt. Der Speicher erreicht eine Transferrate von 8 Terabyte pro Sekunde.

Mehr Infos zum internen Aufbau gab es an der Präsentation kaum. Insgesamt soll der BG200-Beschleuniger im Vergleich zum H100 in angepasster Rechen- und Datengenauigkeit 30 Mal so schnell sein und dabei 25 Mal effizienter arbeiten. Als Vergleich nennt Huang das Training des Chatbots ChatGPT. Dieser sei innerhalb von drei Monaten mit 8000 Hopper-Chips und einer Leistung von 15 Megawatt trainiert worden. Bei Blackwell seien nur 2000 Chips und 4 Megawatt in derselben Zeit nötig.

Tiefere Präzision für mehr Effizienz

Blackwell ermöglicht mit dem 4-bittigen Gleitkommaformat (FP4) ein Format mit nur 16 Zuständen. Das ist weniger Präzise als höher zahlige Gleitkommaformate, wie sie etwa mit FP16 bei Hopper zu finden sind. Gemäss dem Hersteller reicht dies jedoch aus, und erlaube es den Beschleunigern, mit geringen Einbussen bei der Genauigkeit mit wesentlich weniger Daten zu hantieren. Was neben der Verarbeitungsgeschwindigkeit auch die mögliche Modellgrösse verdoppelt.

Bereits Hopper machte sich die Tatsache zunutze, dass Transformatoren nicht alle Gewichte und Parameter mit hoher Präzision verarbeiten müssen. Die Transformer Engine, die auch in der neuen Chip-Generation werkelt, mischt das präzise 16-bittige Gleitkommaformat (FP16) mit dem weniger präzisen 8-bittigen FP8. Bei Blackwell geht Nvidia jetzt also noch einen Schritt tiefer.

Technologie und Gesellschaft faszinieren mich. Die beiden zu kombinieren und aus unterschiedlichen Blickwinkeln zu betrachten, ist meine Leidenschaft.

Vom neuen iPhone bis zur Auferstehung der Mode aus den 80er-Jahren. Die Redaktion ordnet ein.

Alle anzeigen